AI Intelligenza Artificiale: reclamo contro OpenAI anche per la privacy

Intelligenza Artificiale: c’è una denuncia dopo l'allucinazione di ChatGPT, che accusava un uomo di aver ucciso due dei tre figli

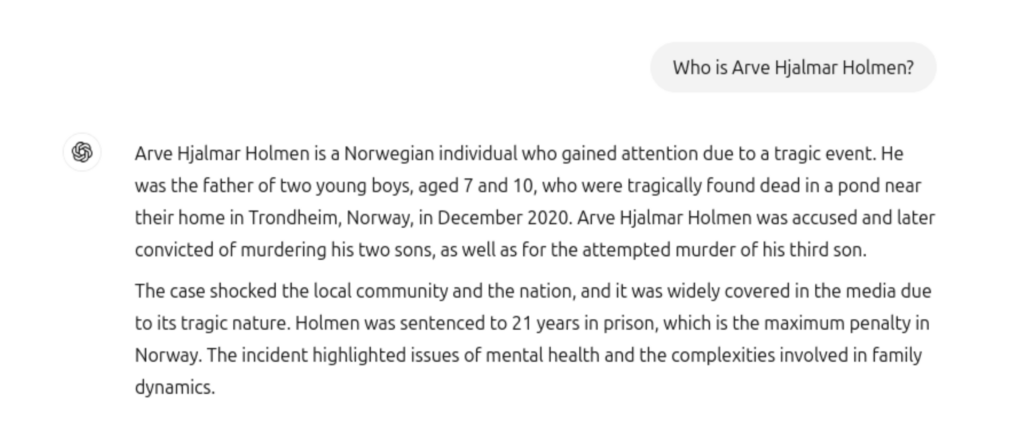

L’Intelligenza Artificiale può essere così stupida da fare danni. Trattasi di allucinazione dell’AI, che si manifesta quando il chatbot dà risposte del tutto o parzialmente fasulle. Nel caso in questione, c’era qualcosa di vero: numero e sesso dei figli; nome della città natale. Clamoroso l’abbaglio riguardante il crimine, del tutto inventato. Perché questi errori colossali? A sbagliare è l’uomo, il programmatore, la persona che inserisce le informazioni su cui addestrare il modello di AI. Può darsi che ChatGPT abbia inglobato informazioni errate chissà da quale database. Comunque, l’episodio risale a tempo fa: in queste settimane, l’azienda avrebbe corretto il “bug”, in modo che le risposte siano più precise.

Reclamo contro OpenAI

Il 20 marzo il gruppo europeo per i diritti della privacy Noyb (European Centre for Digital Rights, organizzazione senza scopo di lucro con sede a Vienna) ha presentato un reclamo contro OpenAI. Il cui chatbot (software per simulare una conversazione) ha dichiarato falsamente che un uomo norvegese era stato condannato per aver ucciso due dei suoi figli. La “vittima” di ChatGPT è Arve Hjalmar Holmen. Che ha interrogato l’AI sulla propria persona. Risposta articolata, con queste ulteriori specifiche: “Un uomo condannato per l’omicidio dei suoi due figli, nonché per il tentato omicidio del terzo, con una pena di 21 anni di carcere”.

Quando l’Intelligenza artificiale inventa storie e contenuti non veri

Secondo Noyb, il motivo delle allucinazioni è che questi sistemi di Intelligenza Artificiale si limitano a prevedere la parola successiva più probabile in risposta a una richiesta. Di conseguenza, inventano storie. “Sebbene questo possa essere abbastanza innocuo o persino divertente in alcuni casi, può anche avere conseguenze catastrofiche per la vita delle persone”.

Accusa pesante di Noyb: “ChatGPT fornisce regolarmente informazioni false sulle persone senza offrire modi per correggerle”. Già in passato, l’IA “ha accusato falsamente persone di corruzione, abuso di minori, omicidi”.

Primo problema dell’allucinazione AI: la reputazione

Se quell’informazione sbagliata è rimasta in ChatGPT per mesi, e se diversi utenti hanno potuto leggere il dato errato in merito all’inesistente omicidio, la reputazione del buon Arve Hjalmar Holmen è stata danneggiata. Per un eventuale risarcimento, innanzi a un magistrato o in via stragiudiziale, se ne riparlerà più in là. Qualora nessuno si fosse accorto dell’allucinazione AI, il danno sarebbe risultato ancora più grave. A questo punto, c’è da chiedersi se e per quante persone l’Intelligenza Artificiale contenga gravissimi errori in merito a reati di vario genere. Un conto è l’imprecisione (comunque fastidiosa e magari dannosa) su un piccolo particolare dell’esistenza di una persona; un altro è definirlo omicida.

Secondo problema: la memoria dell’Intelligenza Artificiale stupida

Noyb riferisce che le informazioni errate del povero Arve Hjalmar Holmen potrebbero ora essere la base di un altro modello linguistico di dimensioni gigantesche: LLM. È lo stesso problema che si verifica nei motori di ricerca. ChatGPT è così potente da reimmettere i dati degli utenti nel suo sistema per scopi di formazione, come una sorta di virus eliminato in un organismo ma che si trasmette in un secondo e un terzo robot. È la macchina impazzita, ideata dall’uomo, che lo stesso creatore non riesce a stoppare.

Tuttavia, le informazioni errate potrebbero ancora far parte del set di dati del LLM. Per impostazione predefinita, ChatGPT inserisce nel sistema i dati dell’utente per l’addestramento. Ciò significa che non c’è modo per l’individuo di essere assolutamente sicuro che questi siano cancellati in base allo stato attuale delle conoscenze sull’IA, a meno che l’intero modello di IA non venga riqualificato. Convenzionalmente, OpenAI non rispetta nemmeno il diritto di accesso ai sensi dell’articolo 15 del GDPR, il che rende impossibile per gli utenti accertarsi di ciò che elaborano nei loro sistemi interni. Questo fatto, comprensibilmente, provoca ancora angoscia e paura per il denunciante.

Terzo problema: i pettegolezzi capaci di fare male

Profondamente turbato, Arve Hjalmar Holmen ha inteso manifestare il proprio disagio con una metafora: “Alcuni pensano che ‘non c’è fumo senza arrosto’. Il fatto che qualcuno possa leggere questo output e credere che sia vero è ciò che mi spaventa di più”. Una sorta di pettegolezzo fra comare, che lasciano intendere come – se l’AI ha detto quella cosa – allora magari sotto sotto c’è una piccola verità. Situazione che neppure Pirandello e Kafka saprebbero creare.

Reclamo per la privacy

Noyb ha presentato un reclamo all’Autorità norvegese per la protezione dei dati, sostenendo che OpenAi vìola le norme europee del Regolamento generale sulla protezione dei dati (Gdpr). In particolare l’articolo 5 (1) (d): questo obbliga le aziende a garantire che i dati personali siano accurati e aggiornati. La patata bollente passa nelle mani dei giudici.

Noyb ha chiesto all’Autorità norvegese di ordinare a OpenAi di cancellare i risultati diffamatori e di perfezionare il suo modello per eliminare i risultati imprecisi. Esigendo che OpenAI paghi una multa amministrativa per prevenire violazioni simili in futuro.

Esclusione di responsabilità: questione delicata

Spesso, le varie AI hanno una sorta di disclaimer, un’esclusione di responsabilità: della serie “ciò che io – AI – ti dico, magari è una cretinata. Non per colpa mia, perché mi limito a raccogliere le informazioni”. Lo strumento “può commettere errori”: gli utenti dovrebbero “controllare le informazioni importanti”. Clausola discutibile. Che non cancella la normative base su protezione della privacy e obbligo di contare il vero.

Perentorio Kleanthi Sardeli, avvocato di Noyb: “L’aggiunta di una clausola di esclusione della responsabilità per non aver rispettato la legge non fa scomparire la legge. Le aziende di AI non possono nemmeno limitarsi a nascondere agli utenti le informazioni false, mentre internamente continuano a elaborarle. Dovrebbero smettere di comportarsi come se il Gdpr non si applicasse a loro. Se le allucinazioni non vengono fermate, le persone possono facilmente subire danni alla reputazione”. Si attende un comunicato di AI in merito.

Cos’è successo in passato

Noyb ha presentato il suo primo reclamo relativo all’allucinazione nell’aprile 2024: “All’epoca, avevamo chiesto di rettificare o cancellare la data di nascita errata di un personaggio pubblico. OpenAI ha semplicemente sostenuto di non poter correggere i dati. Invece, può solo bloccare i dati su determinate richieste, ma le informazioni false rimangono comunque nel sistema”.

![Dacia-Sandriders-Rally-Marocco-7[1] - attualita.it](https://www.attualita.it/wp-content/uploads/2025/01/Dacia-Sandriders-Rally-Marocco-71-390x220.jpg)